TestmanagementDie Welt verändern, ein Bug nach dem anderen…

Business Intelligence (BI) und Datawarehouse-Systeme (DWH)

Unter Business Intelligence bezeichnet man Verfahren und Prozesse zur semantischen Analyse von Daten in elektronischer Form. Ziel ist die Gewinnung von Erkenntnissen, die bessere operative oder strategische Entscheidungen ermöglichen. Intelligence ist im Deutschen als "Information" zu verstehen.

Im Idealfall gibt es ein Business Intelligence Competence Center (BICC), dessen Aufgabe es ist, mit allen Fachbereichen in permanentem Austausch zu stehen, wie durch Business Intelligence Business Benefits erzeugt werden können (BI-Requirement-Management).

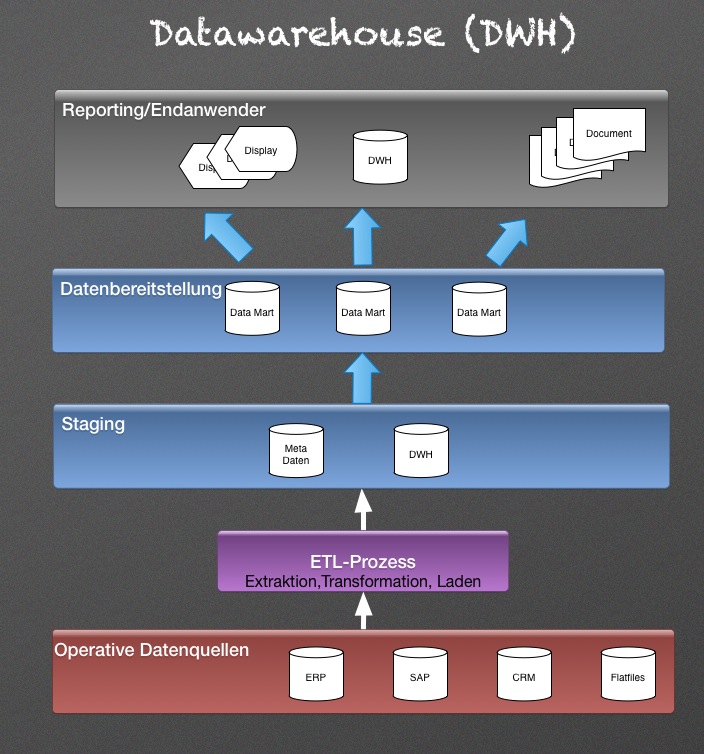

Ein Datawarehouse ist grundsätzlich wie folgt aufgebaut:

Im Idealfall gibt es ein Business Intelligence Competence Center (BICC), dessen Aufgabe es ist, mit allen Fachbereichen in permanentem Austausch zu stehen, wie durch Business Intelligence Business Benefits erzeugt werden können (BI-Requirement-Management).

Ein Datawarehouse ist grundsätzlich wie folgt aufgebaut:

Bereits im ETL-Prozess entstehen eine Reihe von Fragen, die testrelevant sein können:

- Identifikation von fehlerhaften Daten durch Plausiblitätsprüfungen.

- Feststellen von nicht bereinigten fehlerhaften Daten aus Vorsystemen.

- Technische Fehlerquellen, die nicht transparent sind.

- Daten aus heterogenen Quellsystemen wurden nicht harmonisiert und in das erwartete Format des DWH gebracht.

- Möglicherweise fehlen auch Aggregationen, so dass gewünschte Auswertungen nicht erfolgen können.

Auswahl einiger Grundoperationen:

Die Informationsbereitstellung erfolgt in Form von Reports über die Frontends. Hier gibt es eine große Vielfalt von Möglichkeiten.

Eines der Hauptprobleme ist jedoch das By-Pass-Reporting. Dies tritt immer dann auf, wenn Reports auf Basis von parallelen Datenabzügen aus den operativen Systemen erzeugt werden. Dadurch entsteht ein Reihe von negativen Effekten wie beispielsweise:

Eines der Hauptprobleme ist jedoch das By-Pass-Reporting. Dies tritt immer dann auf, wenn Reports auf Basis von parallelen Datenabzügen aus den operativen Systemen erzeugt werden. Dadurch entsteht ein Reihe von negativen Effekten wie beispielsweise:

- keine Reporting-Sicherheit

- Qualitätsverluste

- fehlende Transparenz

- Vertrauensverluste

- Akzeptanzverluste

Neben vielen neuen Begriffen, die in der IT in großer Anzahl entstehen, jedoch meist eine längere Zeit brauchen, um sich durchzusetzen, anbei folgende:

Big Data bezeichnet Daten-Mengen, die zu groß, zu komplex sind, oder sich zu schnell ändern, um sie mit klassischen Methoden der Datenverarbeitung auszuwerten. Der Begriff Big Data unterliegt als Schlagwort derzeit einem kontinuierlichen Wandel. So wird mit Big Data ergänzend auch oft der Komplex der Technologien beschrieben, die zum Sammeln und Auswerten dieser Datenmengen verwendet werden.

Hadoop Distributed File System (HDFS) ist ein hochverfügbares, leistungsfähiges Dateisystem zur Speicherung sehr großer Datenmengen auf den Dateisystemen mehrerer Rechner (Knoten). HDFS unterstützt Dateisysteme mit mehreren 100 Mio. Dateien. Cloudera und Hortonworks sind zwei bekannte Anbieter von Hadoop.

Big Data bezeichnet Daten-Mengen, die zu groß, zu komplex sind, oder sich zu schnell ändern, um sie mit klassischen Methoden der Datenverarbeitung auszuwerten. Der Begriff Big Data unterliegt als Schlagwort derzeit einem kontinuierlichen Wandel. So wird mit Big Data ergänzend auch oft der Komplex der Technologien beschrieben, die zum Sammeln und Auswerten dieser Datenmengen verwendet werden.

Hadoop Distributed File System (HDFS) ist ein hochverfügbares, leistungsfähiges Dateisystem zur Speicherung sehr großer Datenmengen auf den Dateisystemen mehrerer Rechner (Knoten). HDFS unterstützt Dateisysteme mit mehreren 100 Mio. Dateien. Cloudera und Hortonworks sind zwei bekannte Anbieter von Hadoop.

Der Anspruch an ein gut funktionierendes Datawarehouse ist hoch. In vielen Fällen driften Anspruch und Wirklichkeit voneinander ab. Wir versuchen dies zu verhindern.

U

© 2023 Holger Mayer Consulting HMC2 Kontaktieren Sie mich